Einführung in die Suchmaschinenoptimierung

Suchmaschinen wie Google, Bing & Co. sind seit Erfindung des Internets zu den wichtigsten Instrumenten für die Suche nach Produkten, Dienstleistungen oder Informationen geworden.

Diese Entwicklung hat zur Entstehung der Disziplin Suchmaschinenmarketing geführt. Es ist die Disziplin des Online-Marketings, mit der Sie die Besucher von einer Suchmaschine auf Ihre Webpräsenz führen.

Dank der Etablierung von bezahlten und unbezahlten Bereichen auf den Ergebnisseiten der Suchmaschinen (in Fachkreisen SERPs genannt) haben sich im Suchmaschinenmarketing zwei Teildisziplinen herauskristallisiert.

Die Teildisziplinen darin heißen:

- Suchmaschinenoptimierung (kurz: „SEO“ für Search Engine Optimization) und

- Suchmaschinenwerbung (kurz: „SEA“ für Search Engine Advertising).

Oft wird Suchmaschinenmarketing (kurz: „SEM“ für Search Engine Marketing) auch nicht als Überbegriff für die beiden Teildisziplinen verwendet, sondern als Synonym für SEA.

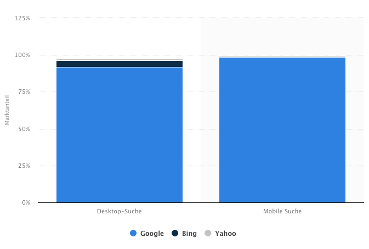

Die besondere Marktsituation im Bereich der Suchmaschinen im deutschsprachigen Raum fokussiert viele Online-Marketer in beiden Disziplinen häufig auf den Weltmarktführer unter den Suchmaschinen namens “Google”.

In Österreich werden insgesamt 92,5% aller Suchanfragen der Menschen auf Google getätigt. Betrachtet man nur die mobilen Suchen auf Smartphones und Tablets, so sind es sogar 95,5% aller Suchanfragen (statcounter.com 2019). In Deutschland sind die Zahlen praktisch identisch.

Das heißt für den deutschsprachigen Raum: Wer „SEO“ sagt, meint vor allem Google-SEO. Wer SEA sagt, meint vor allem Google-SEA.

Was bedeutet nun Google-SEO und Google-SEA? In aller Kürze: Beim SEO geht es um die Verbesserung der organischen Rankings auf den Suchmaschinenseiten und beim SEA um die Anzeigenschaltung auf den Suchmaschinenseiten.

Screenshot google.at unter dem Suchbegriff “online Marketing kurs” (27.2.2019)

Der Ansatz, sich nur auf Google zu konzentrieren, wird jedoch von modernen Profis auch immer wieder kritisch hinterfragt. Die Gründe dafür liegen einerseits darin, dass man sich nicht von einem Suchsystem abhängig machen möchte, andererseits sehen viele Menschen die Wirtschaftspolitik von Google als kritisch an.

Nichtsdestotrotz zeigt die Nutzerverteilung in Deutschland und Österreich bei den Suchmaschinen: 92 von 100 Internetusern nutzen Google als Suchmaschine. Nur 2-3 von 100 Usern nutzen die zweitbeliebteste Suchmaschine Bing von Microsoft. Auch die Nachfrage am Markt, also jene von den Unternehmen, die gerne Suchmaschinenmarketing von den Profis erwerben möchten, ist hierzulande absolut Google-getrieben.

Screenshot statista.com (12.02.2019)

Für Online-Marketing-Profis im Suchmaschinenbereich von absoluter Wichtigkeit ist jedoch auch folgendes Wissen: Die Nutzerverteilung kann von Land zu Land sehr unterschiedlich ausfallen. Im englischsprachigen Raum erfreut sich die Suchmaschine Bing größerer Beliebtheit als in den deutschsprachigen Ländern. In Russland wiederum, wird sogar hauptsächlich die Suchmaschine YANDEX benutzt.

Neben den klassischen Suchmaschinen und SEO-Maßnahmen existieren auch weitere Teildisziplinen in anderen Suchsystemen, die im Normalfall nicht als Suchmaschine bezeichnet werden, wie: YouTube-SEO, Amazon-SEO, Navigationsgeräte-SEO (z.B. Wie schaffen es Tankstellen, dass Ihr Standort im Navigationsgerät eines Pkw angezeigt wird), Alexa-SEO, Siri-SEO etc. Die Sichtbarkeit in diesen Systemen wird unabhängig von Google-SEO optimiert und bewertet.

Auch auf manch anderen Suchsystemen (z.B. Amazon-Suche) als Google kann man Anzeigen schalten und diese in den Suchergebnisseiten auftauchen lassen. Und befindet man sich dabei in einem Suchsystem, so könnte man auch hier wieder (wenn diese Art der Werbung nicht definitiv einer anderen Werbekategorie zugeordnet wird) von SEA im jeweiligen System sprechen.

Zwei interessante Fakten zum Thema Suchmaschinen:

1. Würde YouTube nicht als Video-Plattform, sondern als Suchmaschine gesehen werden, dann wäre YouTube weltweit auf Platz 2 der meist verwendeten Suchmaschinen. Der Suchschlitz über den Videos wird, abgesehen von jenem von Google, deutlich öfter benutzt als der aller anderen klassischen Suchmaschinen zusammen.

2. Würden wir nur produkt-spezifische Suchen betrachten, dann wäre die Suchfunktion von Amazon eine der beliebtesten Suchmaschinen.

In diesem Skript beschäftigen wir uns jedoch mit den SEO-Maßnahmen für den Suchmaschinenriesen Google, da dies auf Grund der Nachfrage bei Unternehmen in Österreich und Deutschland als am wichtigsten empfunden wird.

Diese Marktsituation bringt Vor- und Nachteile für Suchmaschinenoptimierer (sogenannte SEOs) mit sich: Viele wollen sich nur auf Google spezialisieren, da Google der relevanteste Markt im Suchmaschinenmarketing ist. Das erleichtert den Fokus und die Orientierung, weil man sich nur mit den Eigenschaften einer Plattform auseinandersetzen muss. Aber: Alle anderen Mitbewerber wollen auch ein Stück von diesem wertvollen Kuchen. Die gesamte Konkurrenz konzentriert sich ebenfalls auf diesen Markt und er ist stärker umkämpft.

Will man spezialisiert andere Suchmaschinen anvisieren und dort zwar weniger, aber dennoch gewinnbringende Früchte ernten, muss man das den Unternehmen aktuell erst schmackhaft machen.

Das heißt allerdings nicht, dass es schwierig bis unmöglich ist, auf Google voranzukommen. Mit der richtigen Strategie kann man als Unternehmen große Erfolge verzeichnen.

Als SEO (= die Kurzform wir auch als Bezeichnung für Suchmaschinenoptimierungs-Profis verwendet) sollte man sich aber immer auch fragen, ob für das entsprechende Produkt, Dienstleistung etc. Google die richtige Suchmaschine bzw. Plattform für den Marketing-Mix im Allgemeinen ist. So werden beispielsweise Veranstaltungen unter Umständen leichter über Facebook als über Google vermarktet.

Wie hat Google eigentlich den Suchmaschinen Markt erobert?

Die Gründer Larry Page und Sergey Brin hatten mit der Gründung von Google 1998 ein Ziel: Die Informationen der Welt zu organisieren und für alle jederzeit zugänglich und nutzbar zu machen. Ihr Grundgedanke für Suchmaschinen ist die Qualität der Suchergebnisse für Menschen immer weiter zu verbessern.

Dies war und ist bis heute noch der Grundstein des großen Erfolgs von Google. Ohne hochwertige Ergebnisse, die das Bedürfnis der Suchenden treffen, werden die User nicht Google benutzen, sondern wechseln. Da die Ergebnisse so gut sind, werden die User zu zufriedenen Wiederkehrern.

Qualitativ hochwertige Suchergebnisse – Warum und Wann ist ein Inhalt gut?

Die ersten publikumsrelevanten Internetsuchmaschinen wie Excite, AltaVista und WebCrawler waren klassisch an Information-Retrieval-Systemen orientiert. Das bedeutet: Sie setzten ein textstatistisches Ranking ein. Es erfolgte unter der Annahme, dass alle Dokumente, welche in einem Datenset gefunden wurden, potenziell von gleicher Qualität sind (vgl. Broder, 2002).

Das führte gleichzeitig zu einem anderem Problem: Ordnet die Suchmaschine die Treffer nur aufgrund von textstatistischen Verfahren, so geht die Suchmaschine auch davon aus, dass der Suchende automatisch treffsichere Suchanfragen formulieren kann. Er sollte also immer schon das korrekte Wording für seine Suchanfrage kennen (vgl. Lewandowski, 2018, S. 102).

Larry Page und Sergey Brin gingen einen anderen Weg. Die Zeit dafür war auch reif, da die ersten SEOs die rein textbasierten Rankingverfahren sehr leicht “austricksen” konnten. Sehr häufig wurde dadurch nicht der ideale Inhalt für eine Suchanfrage ausgespielt, sondern nur noch der bestoptimierte.

Erst die sogenannten linktopologischen Verfahren in den späten 90er Jahren konnten diesem Problem entgegenwirken und Google war die erste Suchmaschine, die dies in ihrem Index als wichtigstes Rankingkriterium ausrollte.

Doch was heißt das? Mit dem linktopologischen Verfahren ging Google davon aus, dass ein Backlink auf eine Website von einer anderen ein Zeichen für die Qualität des Inhalts der verlinkten Seite darstellt. Man ging von der Tatsache aus: Ein Website-Betreiber würde die andere nicht verlinken, wenn er deren Inhalt nicht für gut befinden würde.

Diese Wende in der Beurteilung von Inhaltsqualität war es, die Google dazu in die Lage versetzte bessere SERPs (= Suchergebnisseiten, Englisch: Search Engine Result Pages) als die anderen Suchmaschinen auszuspielen und somit den Suchmaschinenmarkt als Primus zu erobern.

Natürlich wurden und wird auch das linktopologische Verfahren zur Bewertung der Qualität von Website-Inhalten von SEOs untergraben und manipuliert. Ganze Unternehmen haben sich um den Kauf, Verkauf und Tausch von Backlinks entwickelt und sind mittlerweile teils sogar wieder verschwunden.

Denn Google ist permanent darum bemüht, immer neue Methoden zum Verständnis der Suchanfrage zu entwickeln. Gleichzeitig kämpft Google gegen die Manipulation dieser Qualitätssignale und deckt gewisse SEO-Techniken auch regelmäßig auf. Mit Verbesserungen, sogenannten Updates, des Ranking-Algorithmus versucht der Suchmaschinengigant den Manipulationen Herr zu werden und nur noch den bestmöglichen Inhalt für den User auszuspielen.

Wo steht Google im Jahr 2019?

99% der Menschen, die über Google suchen, finden den gewünschten Treffer auf Seite 1. Ein Suchergebnis wird dann als qualitativ hochwertig bewertet, wenn das Bedürfnis des Users und dessen Suchintention (Search Intent) mit dem Treffer befriedigt wurden. Oder anders ausgedrückt: Google ist bestrebt den Kontext der Suchanfragen und somit die Intentionen zu verstehen und nicht nur nach dem einzelnen Keyword zu suchen.

Das bedeutendste Update zur Erfassung des Search Intent war das Hummingbird Update im Jahr 2013 anlässlich des 15. Geburtstags des Suchmaschinengiganten Google. (Sullivan, 2013).

Wichtig: Die Keywords gelten somit seit einiger Zeit nicht mehr als Hauptbewertungskriterium für das organische Ranking, sondern die Suchintention der User. Google hat festgestellt, dass nicht nur die Keywords, die in der Suchleiste eingegeben werden, für die Suche bewertet werden müssen, sondern vor allem die dahinterstehende Absicht.

Suchmaschinen Optimierung und ihre zwei Teilbereiche

Suchmaschinenoptimierung bezeichnet alle Maßnahmen, um eine Webpräsenz in den organischen SERPs (=Search Engine Result Pages, zu deutsch: Suchergebnisseiten) unter einer bestimmten Suchintention auf eine Top-Position zu bringen.

Grundsätzlich müssen dabei 2 Teilbereiche im SEO beachtet werden:

- Onsite oder Onpage SEO

- Offsite oder Offpage SEO

Wissenschaftstheorie zum Marketing mit Suchmaschinenoptimierung

Die Werbung auf den digitalen Kanälen folgt immer einem dreistufigen Prinzip. Tilo Hildebrandt definiert diese drei Stufen in seinem Buch „Web-Business: Controlling und Optimierung. Wie das Web erfolgreich von Unternehmen genutzt wird“ als Findability-, Usability- und Profitabilty-Ebenen (Hildebrandt, 2016).

Die drei Ebenen sind als Teilbereiche einer Pyramide zu verstehen. Unten am Fuße befindet sich die Findability-Ebene. Dort werden die Besucher für die Website generiert. Umgelegt auf SEO heißt das, dass die Website so optimiert werden soll, dass die richtigen User mit der richtigen Intention die Website möglichst weit oben in den SERPs finden können. Denn je besser (=weiter oben) die Position auf den Suchergebnisseiten, desto wahrscheinlicher der Klick und damit der Seitenbesuch.

In der Mitte befindet sich die Usability-Ebene. Sie bestimmt, wie viele Besucher die letzte Ebene – die Profitability (=Ertragsebene) erreichen. Je mehr Menschen eine Webpräsenz finden (Findability) und je mehr Menschen benutzerfreundlich zum Kauf geführt werden (Usability und Profitability), desto ertragreicher ist eine Webpräsenz.

Konversionspyramide nach Hildebrandt (Findability, Usability, Profitability)

Die Findability-Ebene

Die Findability-Ebene definiert, wie gut die gewünschte Webpräsenz auffindbar ist. Dafür gibt es mehrere Möglichkeiten: Angefangen von Suchmaschinen wie Google, Bing und Co. bis hin zu Portalen, Verbundpartnern, Communities, sozialen Medien etc. Eine Möglichkeit besteht überall, wo sich User theoretisch aufhalten und auf die gewünschte Präsenz (meist die eigene Website oder –Shop), gelenkt werden könnten.

Wichtig ist an dieser Stelle für das Verständnis des digitalen Marketings zu verdeutlichen: Die Findability-Ebene ist es auch, wo in digitalen Marketing-Maßnahmen die Kosten für die Besucher-Generierung entstehen – zum Beispiel für den Klick auf eine Werbeeinblendung oder eben für die Arbeitsleistung der Optimierung im Bereich SEO.

Am leichtesten und deutlichsten zu verstehen ist die Theorie anhand der Pay-Per-Click-Werbung (kurz PPC).

Wie der Name schon sagt, wird bei solchen Werbeformen pro Klick bezahlt – also pro Besucher. Ein klassisches Beispiel dafür wäre die Suchmaschinenwerbung „Google-Ads“ auf der Suchmaschine Google.

Gibt man einen Suchbegriff in die Suchmaschine Google ein, so erhält man auf der Suchergebnisseite bis zu 7 klassische Google-Ads-Anzeigen. Klickt ein User nun auf diese Anzeigen, so bezahlt der Werbetreibende diesen Klick. Im Gegenzug dafür wird der suchende User nun auf die Zielseite des Werbetreibenden geleitet.

Google.at, Suchbegriff “mietwagen berlin” (Screenshot, am 27.02.2019)

PPC-Modelle werden auch auf sozialen Medien wie Facebook oder auf Video-Plattformen wie YouTube etc. angeboten. Diese Art der Werbung ist so beliebt, weil sich Kosten und Nutzen für die Werbung sehr gut gegenüberstellen lassen.

Im Bereich der Suchmaschinenoptimierung entstehen die Kosten zum Ersten in der Arbeitszeit, die für die Optimierung aufgewendet werden muss. Der Profi erstellt hier im ersten Schritt zum Beispiel ein sogenanntes Audit. Dies entspricht einer Analyse der Website und des Linkprofils (=die Auswertung aller verweisenden Backlinks) und der Erstellung damit in Zusammenhang stehender Handlungsanleitungen für die Verbesserung.

In einem nächsten Schritt müssen das Konzept und die neue Struktur umgesetzt werden. Hier entstehen Kosten für die Planung, für die Inhaltserstellung (Text, Bild, Video, Audio), für die Implementierung, Programmierungskosten für diverse Anwendungen, Auszeichnungen und Ausspielungen und auch möglicherweise für technische Optimierungen wie Ladezeitenoptimierung etc.

Auch wenn es ein “Graubereich” der SEO-Disziplin ist, ist sie tagtägliche Realität vieler Profis: Es fallen oft auch Kosten durch Linksuche, Linkverhandlungen und Linkkauf an.

Einen “Graubereich” stellt es deswegen dar, weil es der Linkkauf bzw. -tausch gegen die Richtlinien von Google ist. Schließlich wird damit der Versuch unternommen, die Bewertungskriterien von Google zu unterwandern.

Die Findability bestimmt wie auffindbar eine Webpräsenz ist. Je auffindbarer diese ist, desto mehr User können die Webpräsenz auch tatsächlich erreichen.

Die Usability-Ebene

Usability bezeichnet die Benutzerfreundlichkeit im Web-Business. Sie entscheidet darüber wie hoch die Besucherverluste zwischen Findability und Profitability sind.

Um das zu verdeutlichen: Die User gelangen mit einer Erwartungshaltung auf eine Website. Im Bereich SEO geschieht dies über die Suchergebnisseite einer Suchmaschine. Wird diese Erwartungshaltung nicht innerhalb kürzester Zeit erfüllt, sind die User schnell wieder weg und surfen weiter.

Mit dem ersten Eindruck und der ersten Erwartungshaltung ist es aber noch nicht getan: Vor jedem Klick und mit jeder Scrollbewegung auf der entsprechenden Webpräsenz, baut ein User eine gewisse Erwartungshaltung auf. Und somit ist es die Aufgabe der Usability, also der Benutzerfreundlichkeit, diese Erwartungshaltung zu erfüllen.

Jedes Mal, wenn die Erwartungshaltung nicht erfüllt wird, entsteht ein Frustrationsmoment. Mit jedem Frustrationsmoment steigt die Wahrscheinlichkeit eines Abbruchs. Gleichzeitig sinkt die Chance der Conversion (zu deutsch: Konversion) – also der Umwandlung eines Besuchers in einen Käufer oder großen Interessenten.

Diese Umwandlung ist jedoch das Ziel. Wir sprechen daher von einer wunschgemäß hohen Conversion-Rate (oder zu deutsch: Konversions-Quote).

Diese Konversion kann im Web-Marketing Verschiedenes bedeuten: Bei einem Webshop ist es meist einfach ein Kaufabschluss durch einen User. Ein Besucher wurde also zu einem Käufer. Bei einer Dienstleister-Website ist es vielleicht ein Lead. Ein solcher Lead bezeichnet die erfolgreiche Kontaktanbahnung des Interessenten. Also zum Beispiel ein Anruf, das Absenden eines Kontaktformulars oder eines E-Mails. Nun kann der Dienstleister diesen stark interessierten Menschen von der Qualität seiner Leistungen überzeugen.

Eine hohe Benutzerfreundlichkeit ermöglicht eine hohe Konversionsquote. Daher bildet die Usability-Ebene die unumgängliche Stufe zwischen Findability und Profitability.

Die Profitability-Ebene

Die Profitability-Ebene bezeichnet die Ertragsebene auf der Konversions-Pyramide. Sie besagt, wie rentabel die digitalen Marketing-Maßnahmen für den Werbetreibenden waren.

Mit dem digitalen Marketing im 21. Jahrhundert ist es möglich zu fast 100% Kosten und Erträge gegenüber und miteinander in Verbindung zu stellen. So kann man beispielsweise sehr genau zuordnen, über welche digitale Werbemaßnahme welche Besucher generiert wurden und wie viel (Umsatz/Gewinn) diese eingebracht haben.

Die Profitabilty bildet somit die Grundlage für die Optimierung im Web-Business. Dank der Zusammenführung von Kosten und Nutzen auf dieser Ebene können professionelle Online-Marketer strategische Entscheidungen treffen: In welche Kanäle investieren wir unser Werbebudget sinnvollerweise? In welche Kanäle investieren wir lieber nicht? Wie viel sollte investiert werden? Wie sollte es eingesetzt werden? Etc.

Für die Suchmaschinenoptimierung ist das Marketing-Controlling nicht immer einfach. Im Gegensatz zum direkt berechenbaren Wert in der PPC-Werbung kann es mitunter schwieriger sein, Kosten und Nutzen im SEO gegenüber zu stellen. Schon alleine der Zeitraum stellt die Berechnung vor eine Hürde.

Viele Maßnahmen greifen erst nach einigen Wochen oder Monaten. Hat das Unternehmen, das SEO betreibt nicht genügend Zeitbudget eingerechnet, kann es sein, dass die Suchmaschinenoptimierung im Marketingmix falsch gesehen und eingeordnet wird. Viele Arbeitsstunden, die in die Optimierung gesteckt wurden, rechnen sich erst mit einer gewissen Verzögerung. Daher sollten die Ziele im SEO mindestens mittelfristig, aber eher langfristig gesehen und dann erst Kosten und Nutzen gegenübergestellt werden.

Die Suchmaschinenoptimierung und ihr Content

Nachdem nun die theoretische Funktionsweise von Online-Marketing im Allgemeinen und natürlich auch von SEO bis zur Profitability geklärt sind, bleibt die Frage: Wie lenke ich die Aufmerksamkeit mittels Suchmaschinenoptimierng auf eine Webpräsenz?

Das Schlüsselwort um Aufmerksamkeit zu erregen, heißt Content. Content ist Englisch und bedeutet Inhalt. Die Inhalte im Internet sind Texte, Bilder, Videos und Audiodateien in jeglicher Form oder in Kombination.

Ist ein Inhalt für einen Internetuser interessant, so wird er ihn lesen, ansehen oder anhören. Dann trifft der Inhalt in dem Moment genau sein Bedürfnis. In diesem Augenblick hat es der Content geschafft, Aufmerksamkeit zu erregen – also neugierig zu machen. Der Inhalt spricht somit den User an. Das heißt: War dies das Ziel, war der Inhalt unter einer zielorientierten Betrachtungsweise hochwertig.

Hier schließt sich der Kreis mit dem oben genannten Ziel der Suchmaschinen, insbesondere von Google. Der Internetgigant möchte das perfekte Dokument für den Nutzer passend zu seiner Suchintention ausspielen. Das heißt: Die Maschine versucht zu erkennen wie hochwertig der Content für den Menschen ist.

Betrachten wir das Suchverhalten der Menschen im Internet und berücksichtigen wir, dass 99 von 100 Suchende auf Seite 1 der SERPs finden, was sie suchen, wissen wir, wie gut die Maschine dabei schon geworden ist. Die weitere Entwicklung wird diesen Trend fortsetzen, denn die Mannschaften hinter dieser und allen anderen Suchmaschinen sind bestrebt genau das zu erreichen: Den perfekten Inhalt zur richtigen Zeit an den richtigen User auszuspielen – die Suchintention also perfekt zu treffen.

Das heißt für die Suchmaschinenoptimierung ganz klar: Egal, welche Optimierungsmaßnahmen wir SEOs ergreifen, der Inhalt und dessen Qualität ist bereits und wird langfristig noch immer wichtiger für den Optimierungserfolg.

Dass sich langfristig jener Content durchsetzen wird, der die Bedürfnisse der Nutzer befriedigt, liegt somit auf der Hand. Dabei spielt es keine Rolle, ob es um Unterhaltung, Information, Einkauf oder andere Anliegen geht.

Da Inhalte die Bestandteile des gesamten für den Menschen wahrnehmbaren Internets sind, liegt es auch auf der Hand, dass jede digitale Marketing-Maßnahme von der Qualität des Contents abhängig ist. Die bisherige Internetgeschichte hat gezeigt, dass Strategien, die diesen Aspekt vernachlässigen, nur bedingt funktionieren oder ein Ablaufdatum haben. Wer nachhaltig erfolgreich in der Suchmaschinenoptimierung agieren will, sollte auf hochwertige Inhalte setzen.

Keywords & der Search-Intent

Wenn wir in der Suchmaschinenoptimierung über Keywords und den Search Intent (=Suchintention) sprechen, sprechen wir eigentlich vom Zielgruppenmanagement bzw. der Zielgruppenansteuerung.

Nie war es in der Geschichte des Marketings so leicht möglich, exakt die eigene Zielgruppe zu treffen, wie aktuell im Internet. Internetriesen wie Facebook und Google stellen den Werbetreibenden praktisch die Nutzung der Datenbanken über ihre Nutzer zur Verfügung. Natürlich nicht in Reinform, aber immerhin so, dass man User nach Zugehörigkeit zur Zielgruppe und sogar nach Kaufwahrscheinlichkeit targetieren kann.

Eine wichtige Aufgabe im digitalen Marketing ist aufgrund dieser Möglichkeiten das Zielgruppenmanagement. Ein professioneller Online-Marketer erstellt dabei exakt seine Zielgruppen nach Demographie, nach Eigenschaften und sogar nach der Situation, in der sich die Zielgruppe gerade befindet, wenn sie einen bestimmten Inhalt sehen soll.

Plant der Marketer dies ausführlich und gut, kann er sehr ertragreich digitale Marketingmaßnahmen konzipieren, planen und steuern.

Zielgruppenmanagement in der Suchmaschinenoptimierung

In der Suchmaschinenoptimierung kommt man um das Schlagwort “Keywords” nicht herum. Mit Keywords bezeichnen wir jene Begriffe, die bei der Suche mittels einer Suchmaschine wie Google in den Suchschlitz von den Usern eingegeben werden.

In den organischen SERPs werden jene Dokumente abgebildet, die laut dem Rankingalgorithmus der Suchmaschine das Bedürfnis des Suchenden am besten erfüllen. Das Bedürfnis des Suchenden stellt die Suchintention (engl.: Search Intent) dar.

Google hat schon frühzeitig erkannt, dass die Erfüllung des Search Intents mit hoher Content-Qualität im ausgespielten Dokument der Weg zu den meisten Usern ist. Da der Suchmaschinengigant aus Mountain View seine Forschung und Entwicklung seit Ende der 90er-Jahre darauf konzentriert, hat Google vor allem in der westlichen Welt einen großen Vorsprung.

Insbesondere im deutschsprachigen Raum, versteht niemand die Suchintention der User so gut wie Google. Deswegen konzentriert sich der Suchmaschinenoptimierungsmarkt hierzulande auch größtenteils auf diese Suchmaschine.

Was der Nutzer wirklich sucht, also sein Bedürfnis, offenbart er mit jeder Suchanfrage, die er eingibt (Hazan, 2013). Mit den Suchergebnissseiten erhält der Nutzer eine technisch vermittelte Interpretation seiner Suchanfrage (Lewandowski, 2018).

Digitale Marketer sind darauf angewiesen diese Suchintention ablesen und richtig interpretieren zu können, wenn Sie Erfolg haben wollen. Es geht dabei darum, die Suchanfrage anhand ihrer Absicht, Erweiterung und Autorität richtig zu kategorisieren und zu priorisieren (Jonsen, 2018).

Ausgehend von der Statistik, dass 99 von 100 Suchanfragen bei Google dem Nutzer auf Seite 1 das gewünschte Ergebnis liefert, dürften die Daten, die ein SEO daraus ableiten kann sehr gut sein. Dieser kann also bestimmen, was der Suchende tatsächlich sucht. Schließlich muss es in den meisten Fällen auf Seite 1 der SERPs abgebildet sein.

Die Arten des Search Intents

Für erfolgreiches Zielgruppenmanagement in der Suchmaschinenoptimierung ist es also wichtig, den Search Intent des Users treffsicher bestimmen zu können. Die Wissenschaft macht sich schon länger darüber Gedanken, diese Intention der User zu klassifizieren. Seit Anfang der 2000er-Jahre existiert die Einteilung der Suchanfragen nach Broder in informations-, navigations- oder transaktionsorientierte Search Intents (Broder 2002).

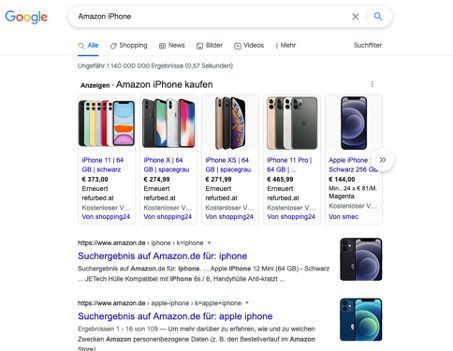

1. Navigational (navigationsorientiert) = Suche nach bestimmter Website im Netz. Zum Beispiel die Suchanfrage “Amazon iPhone” würde hierunter fallen. Der User will exakt zu jener Seite auf Amazon gelangen, auf der er ein iPhone sehen kann. Er will nicht auf irgendeine andere Seite, sondern auf jene von Amazon.

Screenshot der Google Suche nach “amazon iphone” (31.05.22)

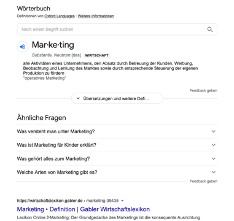

Informational (Informationsorientiert) = Hinter dieser Suchanfrage steht die Absicht eine bestimmte Information zu erhalten. Zum Beispiel die Suchanfrage: “Definition Marketing”. Der User will keine Marketingausbildung machen oder ist auf der Suche nach einer Marketing-Agentur, er will eine Definition finden.

Screenshot der Google Suche nach “Definition Marketing” (31.05.22)

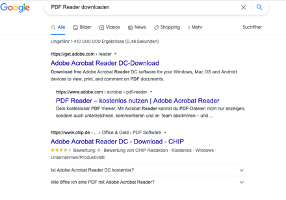

Transactional (Transaktionsorientiert) = Die Suche nach der Möglichkeit eine webvermittelte Aktivität durchführen zu können. Zum Beispiel “PDF Reader downloaden”. In diesem Fall will der User ein Programm downloaden, mit dem er PDFs lesen kann. Ein Download ist eine klassische Aktivität im Internet.

Screenshot der Google Suche nach “PDF Reader downloaden” (31.05.22)

Die oft attraktivsten Suchintentionen in der Suchmaschinenoptimierung für Unternehmen sind transaktionale Suchanfragen mit Kaufinteresse, da diese umsatzrelevant sind. Ein Beispiel dafür “iPhone online kaufen”.

In den Quality Rater Guidelines von Google gibt das Unternehmentan, dass es folgende Suchintentionen am Smartphone gibt:

- Know query entspricht der informationsorientierten Suchintention nach Broder.

- Do query entspricht der transaktionsorientierten Suchintention nach Broder.

- Website query entspricht der navigationalen Suchintention nach Broder.

- Visit-in-person query = der User sucht nach einem Unternehmen/Institution/Organisation und dabei nach der Adresse, Öffnungszeiten etc. Ziel des Users ist es beispielsweise, einen Standort in seiner Nähe ausfindig zu machen (wichtig für Cafés, Restaurants, Tankstellen etc).

- Device Action Queries = Hinter dieser Suchintention steckt das Ziel, dass das Smartphone eine bestimmte Aktion durchführen soll. Zum Beispiel einen bestimmten Kontakt anrufen oder Wetterinformationen aus der Umgebung einholen. Es handelt sich hierbei um eine Unterkategorie der Do-Queries bzw. transaktionalen Suchintentionen nach Broder.

Zusammenhang zwischen Keyword und Search-Intent

Folgt man der Theorie hinter dem Search-Intent und legt man dies auf die Eigenheiten der verschiedenen Menschen um, so steht eindeutig fest, dass nicht jeder Mensch mit dem gleichen Wortlaut nach dem gleichen Produkt sucht.

Hinter jedem Search-Intent stehen somit immer mehrere Keywords. Erschwerend kommt hinzu, dass täglich neue Suchphrasen in die Suchschlitze der Suchmaschinen eingegeben werden, sodass kein SEO der Welt alle Keywords eines Search-Intents kennen kann.

Um das an einem Beispiel zu verdeutlichen: Peter, Anne und Marie wollen sich ein iPhone X kaufen.

Peters Suchanfrage lautet : “iPhone X kaufen”

Annes Suchanfrage lautet : “iPhone X online kaufen”

Maries Suchanfrage lautet: “iPhone X online shoppen”

Die Suchintention ist bei allen drei Suchanfragen die gleiche. Das heißt: Alle drei haben das gleiche Bedürfnis und wollen das gleiche tun.

Um den Unterschied der rein Keyword-basierten SEO-Herangehensweise von früher zur aktuellen Herangehensweise mit dem Search-Intent zu verstehen, kann man Folgendes festhalten: Die Zielseite, auf der die 3 von Google geleitet werden, könnte heute die gleiche sein.

Früher, in der rein Keyword-basierten SEO-Denkschule hätte man 3 Seiten für diese 3 Suchanfragen und einer Implementierung (z.B. nach Häufigkeit des Keywords im Text) erstellt, anstatt sich mit dem Suchbedürfnisses und den erforderlichen Inhalten für die Erfüllung dieses Bedürfnisses auseinanderzusetzen.

Ein moderner Ansatz beschäftigt sich vor allem mit der Erfüllung des Bedürfnisses und versucht dafür das ideale Dokument zu erstellen. Wenn die Intention gleich ist, gilt also 1 Dokument für alle drei Anfragen mit der gleichen Intention. Dafür wird diese bestmöglich erfüllt.

Die bestmögliche Erfüllung der Suchintention beschäftigt sich dann damit, welche Inhalte an welcher Stelle (also zu welchem Zeitpunkt) des Zieldokuments zu sehen sind. Nimmt man einen der vermutlich bestfunktionierenden Shops der Welt, Amazon als Analysebeispiel, so hätte eine gute Seite vermutlich folgende Inhalte und folgenden Aufbau (grob skizziert):

– links oben bzw. oben in der Mitte: Sofort ersichtlicher Produktname -> so weiß der User sofort, dass er hier das gefunden hat, was er gesucht hat (in unserem Beispiel ein iPhone X)

– links oben bzw. links: Gut belichtete Produktbilder bzw. ein Produktvideo.

– Herausstechend (in Größe und Farbe hervorgehoben) in der Mitte: Verfügbarkeit, Lieferzeit und Preis.

– als Bulletpoints schnell und übersichtlich: Die wichtigsten Features und Vorteile

– rechts farblich hervorgehoben: Den “In-den-Warenkorb”-Button

– darunter: Eine ausführliche Produktbeschreibung, die auch die wichtigsten Fragen zum Produkt klärt.

So oder so ähnlich würde vermutlich eine Zielseite aussehen müssen, die den Search-Intent von Peter, Anne und Marie erfüllt. Auf keinen Fall dürfte eine dieser genannten Informationen fehlen. Auch das lässt sich beispielhaft verdeutlichen: Würden Sie jemals ein iPhone online bestellen, wenn Ihnen der Händler den Preis vorher nicht verrät? Würden Sie ihm einfach im guten Glauben die Kreditkarten-Daten geben und denken, er wird schon einen fairen Preis abbuchen? Vermutlich nicht. Das wäre ein “Conversion-Killer”.

Zusammenhang zwischen Keyword, Search-Intent und Customer Journey

Analysiert man in der Suchmaschinenoptimierung nun die Suchintentionen und das Wording der Anfragen seiner Zielgruppe, so ist es offensichtlich, dass die verschiedenen Eingaben in den Suchschlitz die Zielgruppe bestimmen.

Oder anders ausgedrückt: Wenn Peter “iPhone X kaufen” eingibt, so ist gehört Peter zu jener Zielgruppe, die ein iPhone X kaufen möchte – gleich wie alle anderen Personen, die das eingeben. Wenn Phillipp “Samsung Galaxy kaufen” eingibt, so gehört er zu jener Zielgruppe, die ein Samsung Galaxy kaufen möchten usw.

Mit den Keywords und der Suchintention bietet die Suchmaschine aber nicht nur die Plattform, um die richtigen Personen zielgerichtet anzusprechen. Sie bietet auch die Plattform, um sie im richtigen Moment in der Customer Journey (also in der “Reise des Kunden”) für Marketing- & Vertriebszwecke anzusprechen.

Kurz zur Erklärung und Begriffsdefinition: “Die Customer Journey beschreibt den gesamten Kaufprozess des Kunden in verschiedenen Phasen. Die Vorkaufphase ist gekennzeichnet durch die Informationsbeschaffung, die derzeit überwiegend mit Hilfe digitaler Medien stattfindet. Digitale Medien können auch in der tatsächlichen Kaufphase eine entscheidende Rolle spielen.” (Aygün, 2019).

Das heißt, indem SEOs die Dokumente für bestimmte Phasen der Customer Journey optimieren, bereitstellen und erfolgreich in den SERPs platzieren, können Sie nicht nur die Zielgruppe als Personengruppe bestimmen, sondern auch in welcher Phase des Kaufprozesses Sie sich befinden.

Um das an einem Beispiel festzumachen: Peter sucht nach “iPhone X online kaufen” und Stefan nach “Wie gut ist die Kamera des iPhone X”. Beide suchen nach dem gleichen Produkt, aber Peter ist offenbar schon weiter in seiner Kaufentscheidung. Er dürfte wissen, dass er das iPhone kaufen will, während Stefan noch Informationen über das Produkt einholt, die für ihn in der Kaufentscheidung wichtig sind.

Die Keyword-Recherche

Die Keyword-Recherche gehört zu den wichtigsten Vorbereitungsarbeiten in der Suchmaschinenoptimierung. Schließlich bestimmt eine gute Keyword-Recherche, wo man am Ende hin will.

Entsprechend dem Zusammenhang zwischen Keyword, Search-Intent und Customer-Journey kann man mit Hilfe der Keyword-Recherche profitable Ziele für gute Rankings ausmachen und Zielseiten auf die dahinterstehenden Suchintentionen optimieren.

Trotz der Totsagung des Keyword-Denkens durch das moderne Search-Intent-Denkens ist erfolgreiche Suchmaschinenoptimierung noch immer keywordgeleitet. Selbst die detailliertesten Ziel- und Zielgruppendefinitionen helfen nicht weiter, so lange noch der aktive Touchpoint der Suchmaschinenoptimierung mit der Zielgruppe in der richtigen Situation fehlt (Erlhofer, 2019). Und dieser Touchpoint ist der Suchbegriff (=Keyword), der vom User eingegeben wird.

Moderne Keyword-Recherche bedenken jedoch die oben genannte Zusammengehörigkeit mehrere Keywords zu einer Suchintention und fassen daher schon mehrere Keywords zu einzelnen Clustern zusammen, wenn diese dem gleichen Bedürfnisses des Users entsprechen. Die Logik folgt dabei den oben genannten Ausführungen zum Thema Search-Intent.

Welche Daten liefert eine moderne Keyword-Recherche?

Eine detaillierte Keyword-Recherche liefert uns nicht nur stumpf, welche Keywords von Usern gesucht werden oder wie oft diese eingegeben werden. Eine gute Keyword-Recherche kann umfassende Daten liefern, die bis hinein in das Wording und den Wissensstand der Zielgruppe hinein reichen.

Wer eine Keyword-Recherche durchführt, sollte (nachdem er Ziele und Zielgruppe definiert hat) darüber nachdenken, wie diese Zielgruppe nach dem eigenen Produkt/Dienstleistung/Angebot sucht. Am Anfang steht somit meist ein Brainstorming. Zusätzliche Hilfe sucht man sich am besten direkt bei der Zielgruppe – also den Kunden – und fragt diese, wie sie suchen.

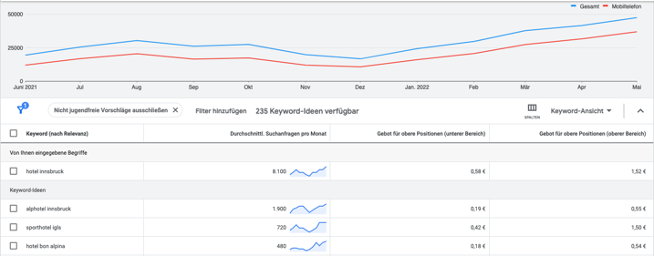

Ausgehend von diesen Daten bedienen sich SEOs verschiedener Tools. Das sicherlich meistgenutzte Tool in dieser Hinsicht ist der Google Ads Keyword Planer. Dieses Keyword-Tool wird eigentlich den Werbetreibenden auf Google zur Verfügung gestellt. Mittlerweile ist es auch nicht mehr komplett kostenlos. Man benötigt aktuell ein aktives Google-Ads-Konto über das bereits ein paar Euro ausgegeben wurden, um brauchbare Zahlen zu erhalten.

Durch den Keyword-Planer erhält man folgende Zahlen direkt von Google:

- Suchvolumen: In der Standard-Einstellung zeigt der Keyword-Planer, wie oft ein gewisses Keyword pro Monat im Durchschnitt der letzten 12 Monate bei Google in der voreingestellten Zielregion mit der voreingestellten Browsersprache eingegeben wurde.

- Konkurrenzsituation bei den Ads: Es liegt in der Natur der Sache des Keyword-Planers, dass Sie hier nur Daten zur Konkurrenzsituation innerhalb des PPC-Universums von Google Ads erhalten. Allerdings können Sie bei hohem Wettbewerb und hohen Durchschnitts-Preisen davon ausgehen, dass auch im SEO die Konkurrenzsituation hoch ist. Allerdings sind diese Informationen nur ein erster Anhaltspunkt zur Bewertung der Konkurrenzsituation und geben in keiner Weise einen echten Einblick. Mehr Anhaltspunkte dazu folgen.

- Weitere Keyword-Ideen: Ein besonderer Zusatznutzen des Planers ist der, dass Sie eine Fülle an weiteren Keywords inklusive Statistik erhalten, die Google Ads zu Ihrer Eingabe gehörig einstuft. So erhalten Sie viele weitere Möglichkeiten, wie auf Google nach Ihrem Angebot gesucht werden könnte.

Screenshot Keyword-Planer Google Ads mit Beispielkeyword hotel innsbruck, eingestellte Nation Österreich, Sprache deutsch (Juni 2022).

Der Keyword-Planer ist aber nur 1 Tool für die Recherche. Alleine nur mit den Google SERPs erhalten sie zusätzlich Auskunft über:

- Die Zielgruppenrelevanz und die Intention Ihrer User: Ausgehend von der Tatsache, dass der User in 99 von 100 Fällen bei Google auf Seite 1 der SERPs fündig wird, verrät uns auch in 99 von 100 Fällen, was dieser gesucht hat. Sehen wir uns also die SERPs unter gewissen Keywords genauer an, so wissen wir, was gesucht wurde.

Wichtiger Hinweis: Da Werbetreibende oft nicht viel Zeit in die Keyword-Recherche stecken, sondern viel zu sehr nach Gefühl agieren, ziehen professionelle SEOs nur die organischen Treffer für Ihre Analyse heran. Nur diese Rankings fußen zu 100% auf dem starken Rankingalgorithmus von Google.

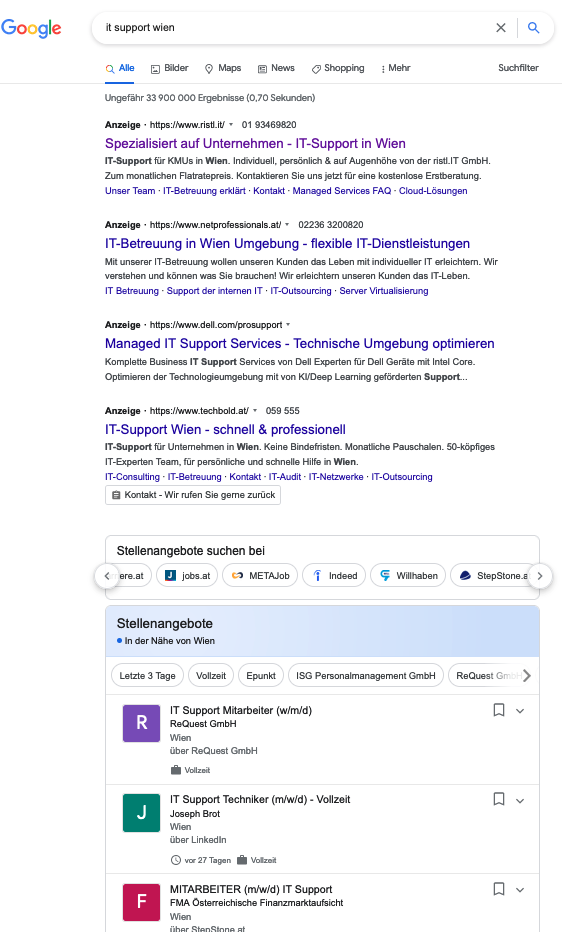

Beispiel für KW-Zielgruppen-Analyse anhand der SERPs, Screenshot Google unter dem Suchbegriff “it support wien” ( Juni 2022 )

Analysiert man die Zielgruppenintention bei dem in der Abbildung gesuchten Keyword “it support wien”, so zeigt sich eindeutig, dass die Werbetreibenden hier vermutlich keine Keyword-Recherche durchgeführt haben. Denn dann würden diese für ihre Dienstleistung unter diesem Suchbegriff vermutlich keine Werbung schalten.

Die organischen Treffer darunter zeigen eindeutig, dass die User, die dieses Keyword nutzen, offensichtlich IT-Techniker auf der Suche nach einem Job sind.

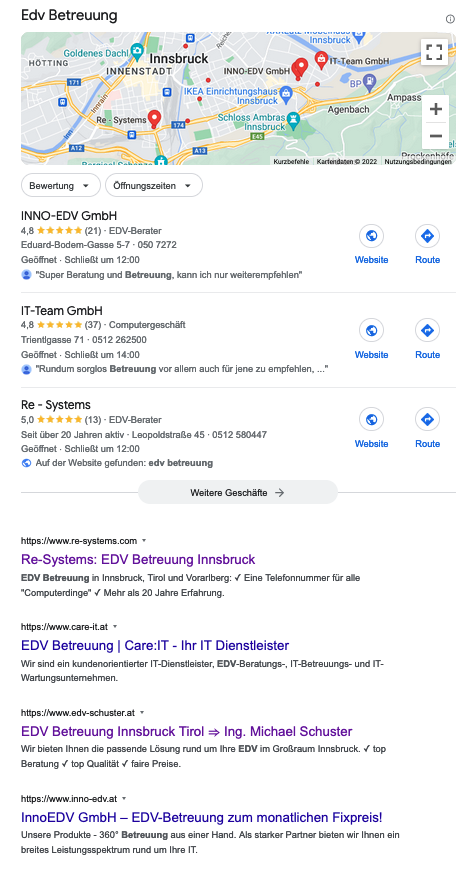

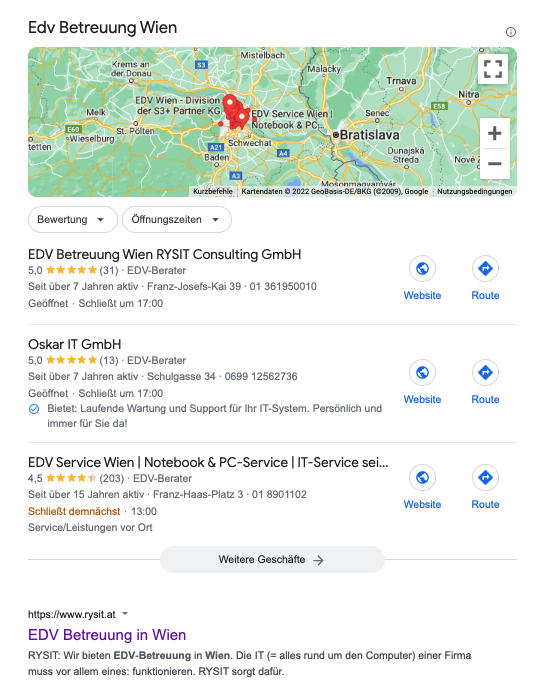

Screenshot Google SERPs unter dem Keyword “edv betreuung wien” (um Anzeigen bereinigt; Juni 2022 )

Betrachtet man diese Abbildung wird ersichtlich, dass im Sinne der Zielgruppenintention ein Ranking für einen Anbieter von IT-Dienstleistungen deutlich ertragreicher sein wird. Während “it support wien” offensichtlich nur Techniker auf Jobsuche eingeben, zeigen die organischen Treffer unter “edv betreuung wien”, dass die User auf der Suche nach einer Firma sind, die diese Dienstleistungen anbieten.

Mithilfe der SERPs lässt sich somit analysieren, ob die User hinter diesem Keyword auf der Suche nach einem Job, einem Anbieter, Waren, Informationen/Definitionen, dem Produktkauf etc. sind.

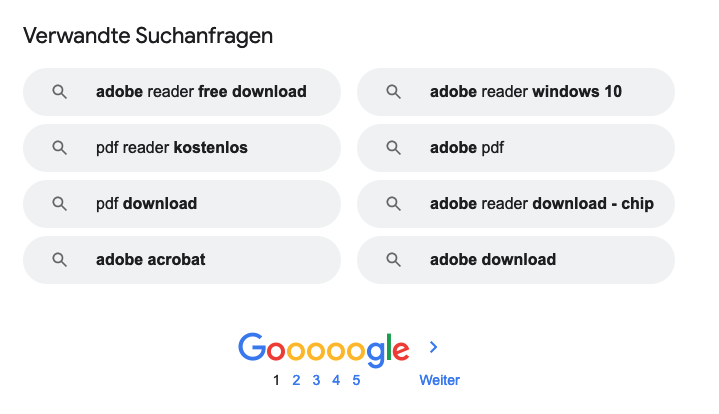

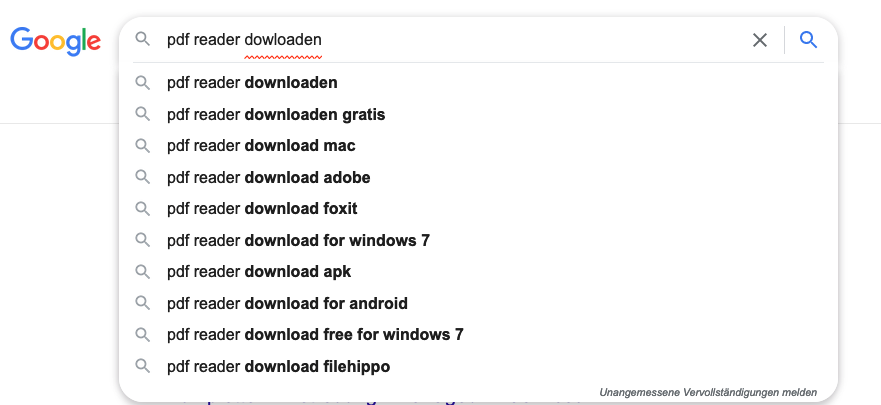

Ebenso finden wir in den Suchergebnissen noch weitere Hinweise darauf, wie Nutzer im Internet in der anvisierten Nische suchen. Durch den Teil der SERPs, den Google mit “Ähnliche Suchanfragen zu …” ganz unten kennzeichnet, sehen wir weitere Keywords, die User in diesem Themenbereich eingeben. Und via Google Suggest (=die Vorschläge, die uns Google schon während der Sucheingabe macht, sehen wir weitere häufige Sucheingaben).

Screenshot “Ähnliche Suchanfragen zu…” unter dem Keyword “pdf reader downloaden” (Juni 2022)

Screenshot von Google-Suggest während einer Sucheingabe (Juni 2022).

Zudem nutzen Suchmaschinenoptimierer zusätzlich Dritttools, um wichtige Keywords herauszufinden. Zu den bekannteren gehören ubersuggest.org, keywordtool.io, MetaGer, Wörterbuch-Tools (für z.B. Synonyme), Market Samurai und einige mehr.

Sollte der Auftraggeber oder der Unternehmer bereits über Website-Daten verfügen, so können Google Analytics (bzw. ein anderes Tracking-Tool) oder die Google Search Console weitere Hinweise über mögliche gute Keywords geben.

Zusätzlich analysieren Profis immer die Seiten der wichtigsten Konkurrenten mit professionellen Dritttools wie Sistrix, ahrefs oder Ryte.

Bei der Keyword-Recherche gehört zur Konkurrenzanalyse auch immer der Blick darauf, wie stark die Konkurrenzsituation ist. Daher werden Dritttools vor allem auch dazu benutzt Folgendes zu analysieren:

- Linkprofil der Konkurrenz: Hierzu sehen sich Profis die Konkurrenzseiten unter relevanten Suchintentionen an, um einschätzen zu können wie leicht oder schwer es ist, bei Google unter diesen Keywords auf Seite 1 zu landen.

- Onsite-Optimierungsgrad der Konkurrenz: Mit Hilfe von Tools wie Sistrix, Ryte oder dem Screaming-Frog scannen Profis im Schnellverfahren die Aufmachung der Konkurrenzseiten durch und sehen somit, wie sauber diese gearbeitet hat.

Die Einschätzung wie stark oder schwach die Konkurrenz in Bezug auf Linkprofil und Onsite-Optimierung einzuschätzen ist, passiert anhand der gleichen Kriterien der bekannten Rankingfaktoren, wie die eigene Optimierung.

Suchmaschinenoptimierung in der Praxis

Was bestimmt die Rankings?

Aktuell existieren mehr als 200 Rankingfaktoren im Google Such-Algorithmus, die SEO-Spezialisten (kurz: SEOs) bekannt sind. Wieviele Faktoren der Algorithmus wirklich beinhaltet und welche das genau in welcher Wichtigkeit sind, ist vielleicht das bestgehütete Geheimnis der Welt.

Vermutlich gibt es aufgrund der maschinellen Weiterentwicklung und der dahinterstehenden künstlichen Intelligenz durch das Google „Rank Brain“ keinen Menschen mehr, der den ganzen Algorithmus überhaupt noch kennt.

Teilweise erfährt der Algorithmus täglich neue Änderungen. Der ehemalige Chef des Google-Webspam-Teams, Matt Cutts, veröffentlichte 2012 folgende Info in seinem Blog:

„Allein im Verlauf des Jahres 2012, gab es 665 Änderungen im Google Algorithmus“ – das wären beinahe 2 Änderungen täglich!

Bei größeren Updates erhält die Web-Community die Informationen manchmal am Tag der Veröffentlichung. Dies passierte in der Vergangenheit durch den oben genannten Matt Cutts oder dem Senior Webmaster Trends Analyst John Müller häufig via Twitter.

Die größten Änderungen bekamen in der Vergangenheit Tiernamen, wie zum Beispiel 2015 das „Google Panda Update“. Die meisten Änderungen im Algorithmus werden jedoch nicht öffentlich bekannt gegeben. Diese erhalten, wenn die Auswirkungen groß genug sind, den Namen von Spezialisten in der SEO-Szene, wie zum Beispiel das „Google Phantom Update“ oder „Google Medic Update“.

Einer der wichtigsten Schritte für Google war mit Sicherheit auch das eingangs bereits kurz erwähnte „Rank Brain“ im Jahr 2015. Es spielt vor allem bei der Ermittlung der relevanten Suchergebnisse für bisher unbeantwortete Suchanfragen eine große Rolle. Der große Unterschied zu den bisher gestarteten Google-Updates besteht darin, dass das System selbst neu dazulernt und die Anpassungen des Algorithmus nicht durch Menschenhand vollzogen werden.

Warum ändert Google laufend den Algorithmus?

Im Großen und Ganzen geht es darum, die besten Suchergebnisse für die Menschen zu garantieren und Spam Möglichkeiten auszuschließen. Mit fortlaufenden Anpassungen kann der Algorithmus immer weiter verbessert und an die Nutzerintentionen angepasst werden.

Als Online-Marketer und SEO-Spezialist sollte man immer dahinter sein, um die Ranking-Faktoren und die Algorithmus-Änderungen mitzubekommen. Mit laufendem Monitoring sowie Auswertungen der Daten, versuchen SEOs diese neuen Veränderungen rasch wahrzunehmen und in ihren Optimierungsmaßnahmen schnell darauf zu reagieren.

Die SEO-Spezialisten werden nach ihren Optimierungsmaßnahmen in zwei Kategorien eingeteilt: Die „White Hat SEOs“ und die „Black Hat SEOs“. Das ist eine Anlehnung an die Western-Filme der 70er-Jahre. Die guten Cowboys trugen darin immer weiße Hüte und die bösen Cowboys immer schwarze Hüte. So sind jene SEO-Spezialisten, die sich genau an die Regeln von Google halten also „White Hat SEOs“ und jene, die mit schmutzigeren SEO-Tricks versuchen den Google Algorithmus auszutricksen die „Black Hat SEOs“ (Mehr dazu in Kapitel 6: Suchmaschinenoptimierung und deren Ausprägungen)

Somit ist ein weiterer Grund für die laufenden Algorithmusverbesserungen von Google, dass der Algorithmus sich auch ständig verändern muss, um schlechtere Suchergebnisse durch Black-Hat-Methoden in den vorderen Treffern zu vermeiden.

In der gängigen Praxis sind die meisten SEO-Spezialisten übrigens irgendwo in der Mitte zu verorten. „Gray Hats“, wenn man so will.

Onsite-/Onpage-Suchmaschinenoptimierung

Innerhalb der Disziplin der Suchmaschinenoptimierung gibt es zwei Teilbereiche, die für SEOs relevant sind, um ihre Arbeit einzuteilen. Zum einen ist das die Onsite- oder auch Onpage-Optimierung und zum anderen ist das die Offsite- oder Offpage-Optimierung.

Die Onsite oder Onpage SEO bezeichnet alle Maßnahmen, die direkt auf der Website gesetzt werden können. Der Vorteil: Die Kontrolle und der Einfluss liegen zu 100% beim Seitenbetreiber.

Da diese Maßnahmen so leicht verfügbar sind, können sie auch als SEO Basismaßnahmen angesehen werden. Denn hier sind Seitenbetreiber von niemandem abhängig. Sie müssen es nur korrekt umsetzen.

Viele Onsite-SEO-Informationen finden Sie ebenfalls im „Startleitfaden für Suchmaschinenoptimierung“ von Google (Google Support Seiten, 2019).

Onsite-SEO beginnt schon bei der gesamten Struktur der Website, geht über die Inhalte und die Inhaltsauszeichnung und bis hin zu technischen Maßnahmen wie Ladezeiten-Optimierung und Meta-Daten.

Die grundlegendsten Onsite-SEO-Maßnahmen im Kurz-Überblick:

#1 Wichtige Parameter: Title, Headers, Description (kein direkter Rankingfaktor) und Url

Der Titel der Seite, die Headers (=Überschriften), die Metadescription und die Url sollten die Intentionen und deren Keyword-Sets oder Variationen enthalten, für die man gefunden werden will. Natürlich sollten diese auch im Inhalt der Seite wieder vorkommen. Schließlich geht es um Themenverbindung zwischen Content und der Darstellung auf Google, die durch Title, Description und Url beeinflusst werden kann.

Bitte verstehen Sie das aber nicht als Einladung, diese Parameter mit Keywords wahllos vollzustopfen. Zu viel wird von Goolge als übertriebene Manipulation erkannt und wie Spam abgestraft. Als Faustregel gilt: Immer dann, wenn es für den Nutzer sinnvoll ist, wird es langfristig bei Google Bestand haben. Alles andere geht in Richtung Minderwertigkeit und wird spätestens mittelfristig von Google mit schlechteren Rankings bestraft.

#2 Saubere Struktur und Code:

Der Quellcode (=in Programmiersprache geschriebener Text) der Website sollte einer Überprüfung unterzogen werden. Ist er fehlerfrei und hält die W3C-Standards (=Standards des Gremiums zur Standardisierung der Techniken im World Wide Web) ein, hat das zwar keine direkten Auswirkungen auf das Ranking, stellt aber sicher, dass die Seiten richtig indiziert werden.

#3 Auszeichnen der relevanten Intentionen durch Überschriften, Fetten, Kursivschrift

Die Crawler der Suchmaschine durchstöbern den Code nach hervorgehobenen Formatierungen. Dies sind Überschriften (<h1>, <h2>, <h3> …), kursive oder gefettete Passagen. Da diese Elemente auch bei der Gestaltung dazu da sind, die wichtigen Teile eines Textes für Menschen zu markieren, geht auch die Suchmaschine davon aus, dass diese Teile wichtig sind. Hier sollten daher auch die anvisierten Intentionen und deren Keyword-Sets vorkommen.

#4 Wichtige und unwichtige Meta-Informationen

Wie bereits unter Punkt 1 erwähnt, sind Seitentitel, Url, Headers und Metadescription wichtige Meta-Informationen für Google. Die Description ist es aber nur indirekt, da sie nur die Klickrate in den Suchergebnisseiten beeinflusst. Laut Matt Cutts, dem ehemaligen Leiter des Webspam-Teams bei Google, werden die von den ersten Suchmaschinen berühmten Meta-Keywords in den Google-Suchergebnissen überhaupt nicht berücksichtigt. Im Gegenteil: Setzen Sie diese falsch ein, werden die Meta-Keywords vielleicht als Spamversuch wahrgenommen. Dieses hartnäckige Gerücht, dass Sie Meta-Keywords setzen müssten, können Sie ignorieren. (Quelle: Google Webmaster Kanal auf YouTube https://www.youtube.com/watch?v=jK7IPbnmvVU, am 27.02.2019)

Wichtig für die Google-Platzierungen sind dagegen noch Metadaten bei Bildern (aussagekräftige Dateinamen, Bild-Titel und Alt-Attribut) sowie bei Videos (Video-Sitemap als Erweiterung der Sitemap).

Immer wichtiger wird zudem die semantische Auszeichnung nach Schema.org. Dahinter verbirgt sich eine einheitliche Auszeichnung mit der HTML-Elemente mit einer semantischen Bedeutung versehen werden. So können Sie zum Beispiel einen Geldbetrag als Preis deklarieren. Dadurch können Suchmaschinen wie Google zweifelsfrei erkennen, dass es sich dabei um einen Preis und keine wahllose Zahl handelt und diesen entsprechend in den Suchergebnisseiten verwerten.

#5 XML-Sitemap

Eine XML-Sitemap sollte auf Websites nicht fehlen. Sie dient den Crawlern dazu, die Struktur der Seite zu erkennen. Google sagt zwar, dass Websites unter 10.000 Unterseiten auch so erkannt werden können, dafür ist aber dann eine perfekte Struktur und interne Verlinkung der Seiten notwendig.

#6 „Content is King“ – aber nur in Balance zwischen Mensch und Maschine

Laut den offiziellen Google-Hilfeseiten sollen die Inhalte auf Websites vertrauensvoll, hilfreich, informativ und kompetent sein. Zudem sollten sie möglichst frei von Rechtschreibfehlern sein, nicht aus Massenproduktion stammen und nicht mit unverhältnismäßig vielen Anzeigen gespickt sein.

Bei der Inhaltserstellung für SEO gilt es jedoch, eine weitere Kunst zu beherrschen: Man muss die Balance zwischen Suchmaschine und Mensch als Leser finden. Viele Spezialisten denken hier noch zu sehr an die Suchmaschine. Allerdings dürfen SEOS für mittel- und langfristige Erfolge nicht vergessen, dass Google seinen Algorithmus stetig verbessert. Zudem ist es das oberste Ziel von Google, das beste Ergebnis für den Suchenden (also den Menschen) zu liefern. Und Google ist da heute schon sehr weit. Manipulative Texttricks, die nur die Suchmaschine austricksen sollen, hatten bislang immer ein Ablaufdatum und werden es vermutlich auch immer haben.

Wichtige Faktoren im Detail: 1. Der Content

Aufbereitung der Seiteninhalte

Bei der Aufbereitung der Inhalte denken viele Laien darüber nach, wie sie an den Inhalten arbeiten können, um gute Suchmaschinen-Rankings zu erhalten. Dabei sollten Sie in erster Linie an die Bedürfnisse und die verwendete Sprache der Zielgruppe und erst in zweiter Linie an die Suchmaschinenoptimierung denken. Die die intelligentesten Suchmaschinen wie Google sind bereits soweit, zu erkennen, ob der Inhalt einer Website am Bedarf des Menschen orientiert ist oder nicht.

Der klassische SEO-Text mit spammigen Tricks wie Keyword-Stuffing (=das oftmalige Wiederholen von bestimmten Suchbegriffen im Text) und Ähnlichem funktionieren nicht mehr. Moderne Ansätze (z.B.: WDF*IDF) versuchen anders die Relevanz eines Dokuments zum eingegebenen Suchbegriff herzustellen.

Das Modell der “Within Document Frequency” (WDF) und der “Inverse Document Frequency” (IDF) geht nicht nur wie ältere Ansätze der Keyword-Dichte von der Wiederholungsrate in einem Dokument aus, sondern handelt von Worttermen die in ganzheitlich, vermutlich gut zum Suchbegriff passenden Texten vorkommen. In der Regel werden dabei die Dokumente untersucht, die ohnehin bereits gute Rankings unter einem Suchbegriff innehaben.

Anhand der Termfrequenzen vom Keyword und Proof-Keywords in diesen Dokumenten kann nun berechnet werden, wie Ihr Text aktuell auszusehen hätte, wenn Sie die maximale Relevanz zum Suchbegriff erreichen wollen. Allerdings ist WDF*IDF keine Zauberformel, sondern nur ein mathematisches Modell, um Textdokumente in ein Relevanzverhältnis zu einem Ausgangssuchbegriff zu stellen.

Dazu sind zweierlei Kritikpunkte in der Disziplin der Suchmaschinenoptimierung zu nennen:

1. Wird von Google nicht offiziell bestätigt, dass sie WDF*IDF nutzen. Und selbst wenn, ist es nur einer von mehr als 200 der uns bekannten Rankingfaktoren.

2. Wird Google langfristig ohnehin immer noch besser, die Suchintention zu erkennen. Die Formel WDF*IDF ist bereits Jahrzehnte alt und kommt aus der Datenbanksuche. Eine Rücksicht auf die Suchintention wie sie Google aktuell mit dem geheimen Algorithmus berechnet findet nicht statt.

Nichtsdestotrotz ist WDF*IDF ein guter Ansatz, um die Optimierung seines Textes zu prüfen. Allerdings werden Sie, wenn Sie die folgenden Regeln für einen guten Text bedenken, ohnehin nicht ohne Proof-Wortterme auskommen, wenn Sie ein Problem oder ein Bedürfnis des Suchenden ganzheitlich beleuchten wollen.

Der Fokus auf die Bedürfnisse der Zielgruppe erhöht zudem die Conversion-Rate einer Website und die Aufmerksamkeit, die sie erreichen wird.

Der Zielgruppe ein gewisses „Wording“ in den Mund legen zu wollen, funktioniert im digitalen Zeitalter nicht. Wobei es falsch wäre, diese Erkenntnis als „Erkenntnis des digitalen Zeitalters“ zu feiern. Denn gute Verkäufer wussten schon vor Jahrzehnten, was auch heute im Internet als Faustregel gilt:

„Nur diejenigen, die im Verkauf (egal ob im Internet oder persönlich im Laden) ihre Interessenten dort abholen, wo diese auch gerade sind, machen das Geschäft.“

Was heißt das nun für die Aufbereitung der Inhalte?

Wenn nicht die Sprache der Zielgruppe verwendet wird, kann es leicht passieren, dass diese das angewandte Wording (auch wenn es in Fachkreisen korrekt ist) nicht versteht. Das heißt: Die Zielgruppe würde es im Extremfall gar nicht merken, dass es um jene Information geht, die sie gerade benötigt.

Zudem können ohne Recherche die Bedürfnisse einer Zielgruppe nur durch Zufall oder Gespür maximal erahnt werden. Zielsicher wissen und ansprechen kann man sie nicht.

Dabei sind die Daten in Unternehmen bzw. im Internet meist in großer Menge vorhanden: Verkäufer kennen die häufigsten Fragen der Kunden, bei Google kann man die der Häufigkeit der Sucheingaben nachvollziehen, Menschen posten öffentlich ihre Bedürfnisse in Form von Fragen in Foren/Blogkommentaren/Facebook-Gruppen etc., E-Mail-Anfragen sind oft zu Tausenden auf den Rechnern von Unternehmen gespeichert.

Werden die darin enthaltenen Daten aus der Zielgruppe mit Inhalten auf der Website entsprechend angesprochen, so wird das Informationsbedürfnis der Zielgruppe mit großer Wahrscheinlichkeit gestillt und der Seitenbetreiber präsentiert sich als vertrauenswürdiger Experte.

Fünf Regeln für guten Content

Es ist nicht immer so einfach, bei der Inhaltserstellung diesen Inhalt auch hochwertig zu verfassen. Daher finden Sie im Folgenden 5 Regeln für hochwertigen Content. Übrigens ist es egal, welche der vier Formen von Content (Text, Bild, Video, Audio) produziert wird. Diese Regeln sollte jede Form beachten.

1. Bedürfnis ansprechen:

Um das zu erreichen, bedarf es viel Recherche. Wonach und wie sucht die Zielgruppe im Internet? Welche Fragen stellen Interessenten in Foren, auf sozialen Plattformen etc.? Genau das sollten die Aufhänger guter Inhalte sein. Dann treffen Sie den Nerv der potenziellen Kundschaft. Das Bedürfnis der Zielgruppe kennen digitale Marketer, wenn in der Konzepterstellung Ziel, Zielgruppe und Bedarf der Zielgruppe sauber herausgearbeitet wurden. Die Keyword-Recherche hilft zudem Bedürfnisse zu erkennen und zu analysieren. Mehr zur Keyword-Recherche erfahren Sie in diesem Beitrag: “Die Keywordrecherche” (erscheint bis spätestens 31.07.22)

2. Keine Floskeln:

Langweilen Sie Ihre Zielgruppe nicht mit Floskeln. Diese machen Inhalte meistens schlechter. Auch wenn es sich gut anfühlt, einen Text mit einem berühmten Zitat zu beginnen, ist der Informationsgewinn für den User meistens gleich Null. Damit haben Sie seine Zeit verschwendet und sein Informationsbedürfnis überhaupt nicht gestillt.

Nur in Ausnahmefällen regen Floskeln oder Zitate zum Weiterlesen an. Achten Sie dabei auch auf „Marketing-Kauderwelsch-Worthülsen“. Diese bösen Feinde eines gelungenen Textes verstecken sich oft sehr gut. Wir haben uns nämlich schon so an sie gewöhnt, dass sie kaum auffallen.

Ein klassisches Beispiel: „Der Unterschied liegt im Detail.“ Würden Sie wirklich einen Text lesen, der mit einer solchen Überschrift beginnt? Oder lieber einen, der Regel 3 berücksichtigt …?

3. Konzentrieren Sie sich auf Benefits und klar zu Fassendes:

Angenommen Sie sind auf der Suche nach einem neuen Schreibtischstuhl. Ihr alter Schreibtischstuhl ist durchgesessen und unbequem. Nach einem langen Arbeitstag haben Sie oft Rückenschmerzen. Sie suchen im Internet und stoßen auf zwei Anzeigen. Beide zeigen einen Stuhl im Bild und jeweils eine dazugehörige Bildunterschrift. Die erste lautet: „Der Unterschied liegt im Detail.“ Die zweite: „Wie Sie mit Stuhl X Rückenprobleme vermeiden.“ Welche Anzeige würden Sie anklicken, um mehr darüber zu erfahren?

4. Korrekte Rechtschreibung und Grammatik:

Kennen Sie Websites, E-Mails, Werbematerial mit fehlerhaften Texten? Mit Sicherheit! Und wie wirkt es auf Sie? Seriös? Wohl eher nicht. Daher sollten Sie beim Verfassen Ihrer Inhalte auf korrekte Rechtschreibung und Grammatik achten.

5. „Flotte Schreibe“:

Wahrscheinlich kennen Sie spannende Texte. Sie sind förmlich durchgeflogen. Jede Zeile schoss nur so in Ihren Kopf. Sie haben wahrscheinlich aber auch schon Texte gelesen, die bis ins letzte Detail, bis hin zu jedem formvollendeten Buchstaben ganz anders waren. Jeder Satz war endlos verschachtelt, extrem mühsam zu lesen und das Durcharbeiten der Zeilen und Absätze glich einer endlosen Sisyphus-Strafe. Nur langsam kam man vorwärts, weil man immer wieder und wieder zurück schauen musste, was am Anfang eines solch endlos verschachtelten Satzes stand.

Haben Sie es hier gemerkt? Die ersten drei Sätze des Absatzes „flossen“ irgendwie schneller. Die letzten Drei zogen sich in die Länge.

Um den Effekt einer „flotten Schreibe“ zu erreichen, müssen Sie drei Dinge berücksichtigen:

- Schreiben Sie aktive, kurze Sätze.

- Verwenden Sie keine Fremdwörter und Fachbegriffe.

- Benützen Sie die Sprache Ihrer Zielgruppe. Zu hochgestochen wirkt wie der sprichwörtliche Stock im Allerwertesten, zu „cool“ wirkt unreif.

WICHTIG: Bringen Sie die User nicht aus dem Lesefluss. Muss er stocken oder kann er der Information nicht mehr folgen, so wird er mit großer Wahrscheinlichkeit aufgeben und zur Konkurrenz wechseln. Die ist im Internet nur einen Klick entfernt.

Plagiat bzw. Duplicate Content als Rankingnachteil

So manch Website-Betreiber, der unter Umständen eine Abkürzung sucht, könnte nun versucht sein, den Inhalt der bestrankenden Seiten zu kopieren. Was schon vor der Zeit des Internets verboten war und Plagiat genannt wird, führt auch im Internet nicht zum Erfolg – rechtliche Konsequenzen vorbehalten.

Zwar ist Google kein Gesetzgeber und verfolgt Plagiate nicht rechtlich, allerdings erkennt Google solch “geklaute Inhalte” und verortet diese als Duplicate-Content. Die Suchmaschine geht dabei davon aus, dass ein kopierter Inhalt nicht besser sein kann als das Original und “bestraft” die Kopie daher mit schlechteren Rankings.

Der Hintergrund dafür ist in der Überlegung nach dem Mehrwert der Suchergebnisse für den Nutzer leicht gegeben. Angenommen der Algorithmus würde auf Platz 1 nicht das gewünschte Ergebnis liefern, würde die Kopie auf Platz 2 den Nutzer auch nicht besser befriedigen können. Will Google also mit den vorderen Suchergebnisseiten die Suchintention treffen, muss der Suchgigant zwangsläufig Plagiate nach hinten reihen.

Wichitge Faktoren im Detail: 2. Die Technik

Die optimale Technik ist in der Suchmaschinenoptimierung ein sehr ausführlich behandeltes Gebiet. Sehr viele SEOs kommen aus dem (programmier)technischen Umfeld und zudem konzentrieren sich viele Anweisungen auch direkt von Google darauf.

Es liegt in der Natur der Sache der Digitalisierung, dass die Technik immer eine große Rolle spielen wird. Im ca. 1000 Seiten umfassenden Standard-Werk über Suchmaschinenoptimierung von Sebastian Erlhofer “Suchmaschinenoptimierung – Das umfassende Handbuch” nimmt die Technik alleine rund ein Drittel des Buches ein.

Alle Maßnahmen, die in der Suchmaschinenoptimierung heute dazugehören vollständig zu erfassen, würde den Rahmen dieses Skriptums sprengen. Allerdings will hier der Anspruch erhoben werden, den Tag-konzentrierten Überblick aus der Einleitung dieses Kapitels deutlich zu erweitern.

#1 Barrierefreiheit

Barrierefreiheit im Internet gleicht jener, wie man sie aus dem täglichen Leben kennt. Barrierefreie Duschen, WCs, Zugänge etc. kennt jeder von uns aus der Gebäudetechnik.

Barrierefreiheit im Web ist das gleiche. Es geht darum, Menschen mit einer Einschränkung die Inhalte der Website leicht zugänglich zu machen. Zu leicht ist man aber versucht dies im Internet auf Sehbehinderungen zu reduzieren. In Wahrheit kann auch schon ein Smartphone eine solche Einschränkung bedeuten, da der Bildschirm kleiner ist und man die Seite eventuell nicht so gut lesen kann.

Diese Überlegungen klingen einfach, sind aber allzu oft nicht gut umgesetzt. Mit manchmal verheerenden Ranking-Auswirkungen. Denn auch für die Suchmaschinenoptimierung hat die Barrierefreiheit eine maßgebliche Bedeutung: Auch Suchmaschinen können ohne Hindernisse die auf Websites bereitgestellten Inhalte einwandfrei lesen und verarbeiten, wenn diese barrierefrei sind.

Um die Barrierefreiheit zu gewährleisten sollten Sie mindestens Folgendes beachten:

- gut indexierbare Inhalte

- verzichten Sie auf nicht oder schlecht indexierbare Formate bzw. Technik (z.B. Flash oder Frames)

- gültiges HTML und CSS und korrekter Einsatz von HTML-Tags

#2 Navigation

Wer nun denkt, dass die Navigation ganz klar für den Menschen da ist, der sieht das absolut richtig. Ebenso wie die Barrierefreiheit ist dieses Thema natürlich auch eng verwandt mit der Usability. (Näheres zur Usability finden Sie weiter unten im Blogbeitrag)

Allerdings nutzt auch der Crawler die Struktur der Navigation einer Seite, um alle Seiten nach und nach zu erreichen und im Idealfall danach zu indexieren. Das heißt: Was für den Menschen gilt (wenn er über die Navigation jede Seite bequem erreichen kann), gilt auch für die Suchmaschine.

Helfen können SEOs dem Crawler indem sie, auf eine klare Struktur achten und beispielsweise XML-Sitemaps via Google Search Console an die Suchmaschine mitteilen. Auch eine User-Sitemap (also eine Sitemap auf der Site) kann helfen die Seiten rasch vom Crawler erfassen zu lassen. Wichtig ist hierbei allerdings, dass es sich bei der User-Sitemap um eine HTML-Seite handelt und nicht um ein für die Suchmaschine nicht oder nur schlecht lesbares Flash-Element.

Oft vergessen in Bezug auf die Navigationsstruktur ist die 404-Fehlerseite. Dies ist die Seite, die der Browser ausspielt, wenn unter einer Url das Zieldokument nicht mehr auffindbar ist. Wenn man diese gut gestaltet, zeugt das auch von einem guten Navigationsinstrument. Hier gilt das Motto: Wenn es Ihnen mit einer guten Fehlerseite gelingt, den Nutzer auf Ihrer Seite zu halten (weil er darüber sein Ziel doch noch finden kann) und diesen nicht zu Google zurückschickt, ist das gut für Ihre Suchmaschinenoptimierung.

Über allen hier genannten Maßnahmen zur Navigation steht im Sinne der Suchmaschinenoptimierung aber die Tatsache, dass die Navigation auch crawlbar ist. Das heißt: Die Navigation sollte für Mensch und Maschine leicht lesbar sein, es sollte keine Technik eingesetzt werden, mit der die Suchmaschine nicht zurechtkommt.

Sollten Sie für den User (und die Suchmaschine) innerhalb des Contents Navigationselemente nutzen (also interne Verlinkungen aus dem Text heraus), so müssen Sie darauf achten, einen aussagekräftigen Ankertext (=der klickbare Text hinter dem sich der Link verbirgt) zu verwenden, denn das sagt dem User und der Suchmaschine, worum es auf der Zielseite geht. Im Idealfall ist damit auch eine Suchintention abgedeckt.

Zusätzlich sollten Sie bei internen Verlinkungen darauf achten, dass diese nicht ins Leere (also auf eine 404-Fehlerseite) gehen. Das Dokument auf das verlinkt wird, soll auch gefunden werden.

#3 Semantische Struktur und Auszeichnung mit Mikrodaten

Schon die gedachte Struktur der Auszeichnungssprache HTML folgt einer semantischen Struktur. Semantik heißt soviel wie Bedeutungslehre und bezeichnet die Theorie der Bedeutung der Zeichen.

Im Online Marketing im Allgemeinen und in der Suchmaschinenoptimierung im Besonderen kommt der Semantik eine spezielle Bedeutung zu. Denn, obwohl Google vermutlich eine der besten künstlichen Intelligenzen der Welt besitzt, ist auch die Suchmaschine aus Mountain View aktuell noch eine “dumme Maschine”.

“Dumm” ist nicht auf den Bildungsstand der Suchmaschine bezogen, sondern darauf, sicher gewisse Daten zu interpretieren, wenn das Schema neu oder nicht gekennzeichnet ist.

Um das an einem Beispiel zu erläutern: Für einen Menschen in Österreich ist klar, wenn eine Zahlenfolge mit “+43 664” beginnt und im Kontext des Textes nun eine Telefonnummer folgen sollte, dann handelt es sich hier um eine Handynummer.

Eine Maschine ist sich dessen nur ganz sicher, wenn diese Zahlenfolge auch als Telefonnummer ausgezeichnet ist. Andernfalls besteht für die Maschine immer das kleine Restrisiko, dass es sich um etwas Anderes handelt.

Semantische Struktur im HTML

Die Struktur in der Auszeichnungssprache HTML gibt bereits eine kleine semantische Ordnung vor. So ist zum Beispiel ein H1-Tag die wichtigste Überschrift in einem Dokument. Ein H2-Tag die zweitwichtigste Überschrift. Das entspricht dem Aufbau eines Buches und somit einer logischen Folge.

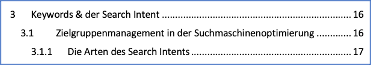

Am Beispiel dieses Skriptums können wir das bereits darstellen:

Ein Kapitel des Skriptum heißt “Keywords & der Search Intent”, die erste Unterüberschrift lautet “Zielgruppenmanagement in der Suchmaschinenoptimierung” und die nächste untergeordnete Überschrift “Die Arten des Search Intents”

In einer sauberen HTML-Struktur, die semantische Regeln beachtet würde dieses Kapitel nun folgendermaßen ausgezeichnet aussehen:

<h1>Keywords & der Search Intent</h1>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

<h2>Zielgruppenmanagement in der Suchmaschinenoptimierung</h2>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

<h3>Die Arten des Search Intents</h3>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

Diese Struktur würde der Suchmaschine Google sagen, dass es in erster Linie um Keywords und den Search Intent geht und die untergeordneten Absätze und Überschriften dazugehören.

Vor allem in der semiprofessionellen Suchmaschinenoptimierung kommt dann häufig gefährliches Halbwissen zum Einsatz. Die semantische Struktur von HTML wird dann beispielsweise so interpretiert, dass ein H1-Tag besonders wichtige Abschnitte ausweist. Und weil die “Halbprofis” dann bei sich alles als wichtig kennzeichnen wollen, wird praktisch jede Überschrift in ein H1-Tag gepackt. Das ist tatsächlich ein häufiger Fehler, der aber die semantische Struktur von HTML komplett zerstört und für die Suchmaschinen unleserlich und uninterpretierbar macht.

Beispiel wie es nicht aussehen sollte:

<h1>Keywords & der Search Intent</h1>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

<h1>Zielgruppenmanagement in der Suchmaschinenoptimierung</h1>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

<h1>Die Arten des Search Intents</h1>

<p>Hier steht der Text dieses Kapitels. Dieser Absatz ist nur ein Platzhalterbeispiel</p>

Ein Buch (um diesen Aufbau auf ein anderes Medium umzulegen) mit nur Hauptüberschriften würde einem Menschen komplett unstrukturiert vorkommen. Und genau so verhält es sich mit der Suchmaschine, wenn sie ein HTML-Dokument im Netz interpretieren muss.

Wichtig: Bitte behalten Sie im Hinterkopf, dass die Heading-Tags nur ein Beispiel für semantische Struktur im HTML sind. Als tieferen Einstieg in dieses Thema empfehlen wir das Buch “Suchmaschinenoptimierung – Das umfassende Handbuch” von Sebastian Erlhofer und eine spezifische Auseinandersetzung mit der Auszeichnungssprache HTML.

Semantische Auszeichnung mit Mikrodaten

Google empfiehlt bei diesem Thema grundsätzlich die Auszeichnung mit HTML-Mikrodaten. Das beginnt bei einfachen Dingen, wie Angaben zu einer Person (einem Autor im Netz) geht über die Einbindung von Erfahrungsberichten/Bewertungen direkt in die Suchmaschinen (die orangenen Rating-Sterne) bis hin zu Video-Boxen oder sogar großflächigen Boxen auf den Suchergebnisseiten.

Für die Ausspielungen von Bewertungen und Co. benötigt Google die semantische Auszeichnung, da Google nur dann mit Sicherheit wissen kann, dass das Ergebnis, das die Suchmaschine ausspielt auch richtig verstanden wurde. Das oben genannte Beispiel mit dem Verständnis einer Telefonnummer ist nur eine Kleinigkeit und stellt eher keine Hürde dar. Wogegen verifizierte Bewertungen, die ja durch die Google-Darstellung auch eine gewisse Glaubwürdigkeit erlangen, schon schwieriger sind. Die Schwierigkeit liegt für Google nicht in der Darstellung, sondern in der Bewertung der Vertrauenswürdigkeit der Daten.

Technisch empfiehlt Goolge wie Eingangs des Kapitels erwäht HTML-Mikrodaten, aber auch die beiden anderen geläufigen Formate (Mikroformate und RDFa-Auszechnung) werden interpretiert. Ist es nicht möglich entsprechenden Code in die Webdokumente einzufügen, so können über den Google-Data-Highlighter in der Google Search Console auf einfachem Wege mit dem Mauszeiger Teile von Websites (wie Bilder, Video, Preise, Adressen, Telefonnummer, Logos etc.) markiert und ihren Semantiken zugeordnet werden. Allerdings kennt die Semantiken dann nur Google. Alle anderen Suchmaschinen (wie Bing) erhalten keinen Zugriff darauf. Das ist der Nachteil des Data Highlighters im Verhältnis zur Auszeichnung im Code.

Die Art der auszeichenbaren Daten wird ständig erweitert bzw. kann bei Schema.org gut nachgelesen werden. Dennoch sollen die wichtigsten Gruppen ohne Anspruch auf Vollständigkeit hier genannt werden:

- Einzelne Erfahrungsberichte

- Aggregierte Erefahrungsberichte

- Personen

- Produkte

- Unternehmen und Organisationen

- Videos

- Breadcrumbs (bei langen Urls kann die Breadcrumb-Navigation anstelle der Urls in den SERPs auftauchen)

- Rezepte

- Events etc.

Google stellt mit dem Testtool für strukturierte Daten auch die Möglichkeit zur Verfügung, die korrekte Einbindung der semantischen Auszeichnung zu überprüfen (Link: https://search.google.com/structured-data/testing-tool?hl=de).

Wie können die Rich Snippets aussehen?

Snippets (deutsch: “Schnipsel”) nennt man im Suchmaschinenmarketing die einzelnen Treffer auf der Suchmaschinenergebnisseite. Diese Snippets können klassisch aussehen, also nur Seitentitel, Url und Metadescription enthalten, oder eben mit Elementen der Markup-Auszeichnung angereichert sein – dann nennt man sie “Rich Snippets” (also wörtlich übersetzt “reiche Schnipsel”).

Im Folgenden sollen hier einige Darstellungsmöglichkeiten und Erweiterungsmöglichkeiten von Snippets gezeigt werden. Wichtig: Ein Anspruch auf Vollständigkeit wird weder erhoben, noch ist er überhaupt möglich. Schließlich wird von Google ständig an den SERPs herumgebastelt und versucht, diese zu verbessern:

Das klassiche Basissnippet mit den bekannten Elementen:

Screenshot Wikipedia Snippet bei Suchbegriff “Wikipedia” (Juni 2022)

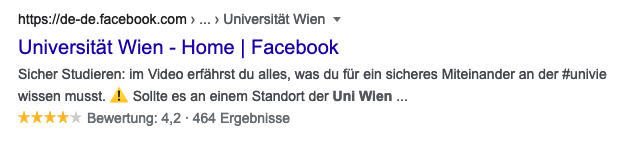

Rich Snippets mit verschiedenen Elementen:

Screenshot Google Snippet von Facebook beim Keyword “Universität Wien”. Das Snippet zeigt aggregiierte Erfahrungsberichte mit Sternen und die Bread-Crumb-Navigation (Juni 2022)

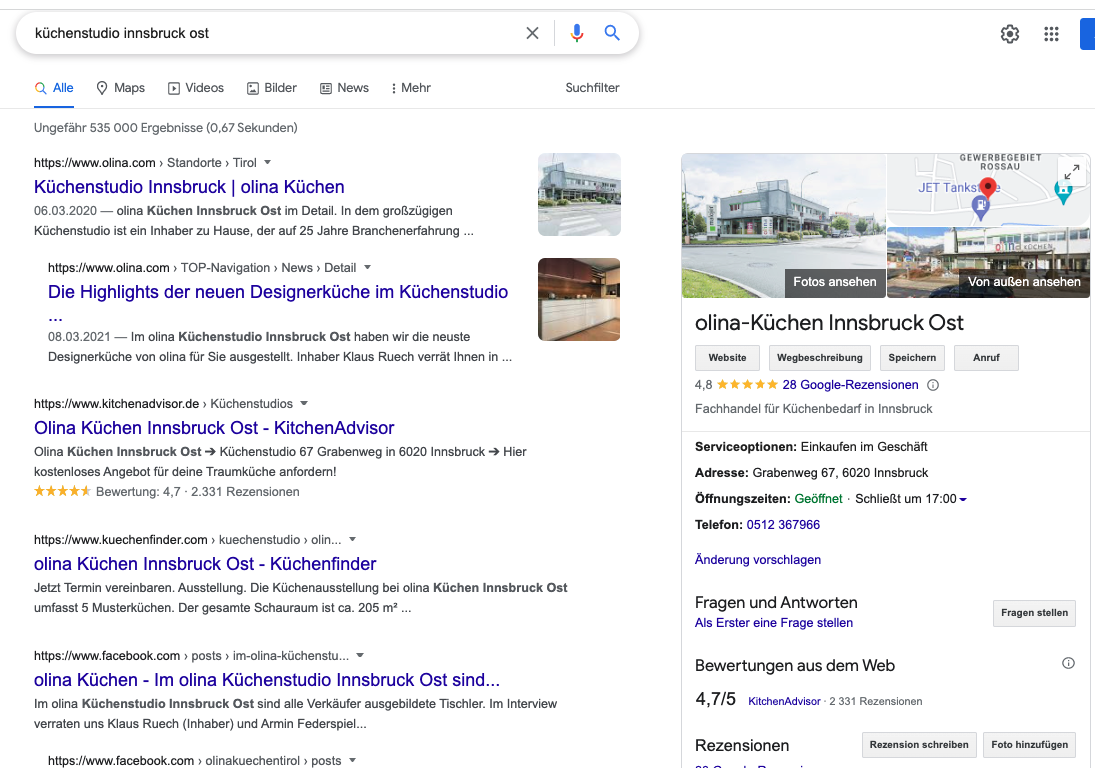

Screenshot der Google Suche unter dem Keyword “Küchenstudio Innsbruck Ost”. Man sieht rechts neben Treffern eine Local-Pack-Einspielung aus einem Google-My-Business-Eintrag (Juni 2022)

Suchergebnis-Screenshot unter “EDV Betreuung Wien” mit Universal-Search Ergebnis eines 3er-Local-Packs gespeist aus Google-MyBusiness-Einträgen (Juni 2022)

Screenshot Compilation Suchbegriff “Sigmund Freud” (Juni 2022)

Compilation und Answer Box (auch Position Zero genannt) zum Suchbegriff “Vorsorgewohnung” (Juni 2022)

Suchergebnis unter dem Keyword “Wiener Schnitzel” mit Rich Results (früher Rich Cards), Compilation, aggregierten Erfahrungsberichten auf Platz 1 und YouTube-Einblendungen der Universal Search (Juni 2022)

Allein diese kleine Beispielsammlung macht deutlich, wie unterschiedlich Suchergebnisse bereits aussehen können. Google beweist damit, wie stark die Suchmaschine auf den Search-Intent eingeht und diesen bestmöglich erfüllen möchte.

Zusatzinfo: Kurz sei hier noch erwähnt, dass nicht alle der abgebildeten Ergebnisse nur durch die Markups auf den Seiten bewerkstelligt werden. Die Local-Pack-Ergebnisse werden durch Optimierung der Google-MyBusiness-Einträge und die YouTube-Ergebnisse durch die Optimierung der YouTube-Videos erreicht. Aber diese Beispiele sollen hier auch veranschaulichen, wie weit man heute als SEO in der Suchmaschinenoptimierung, im Verständnis des Search-Intents und in der (semantischen) Auszeichnung auf allen Kanälen gehen kann und soll.

#4 Die Usability

Betrachtet man die Herangehensweisen, die vor allem von Laien und semi-professionellen SEOs täglich angewandt werden, so möchte man die Auffassung erhalten, dass Google die Art und Weise vorgeben möchte, wie wir Menschen eine Website nutzen sollen.

Die Wahrheit liegt jedoch im genauen Gegenteil: Durch die “Betriebsblindheit” vieler Marketing-Laien und Semi-Profis wird oft angenommen, dass der eigene Content, das eigene Design und die Benutzerfreundlichkeit (=Usability) ohnehin “super seien” und nur Google das nicht erkenne und deswegen mit schlechten Rankings abstrafe.

Es ist nicht abzustreiten, dass es möglich ist, den Algorithmus mit gewissen Techniken zu manipulieren. Allerdings hat Google seit 1998 bewiesen, dass die Tricks, die nicht auf die Optimierung des Contents und der Usability für den Nutzer ausgelegt sind, irgendwann ein Ablaufdatum hatten oder in Zukunft haben werden.

Schon allein der Inhaltsaufbau eines Dokuments wie er von Google im “Startleitfaden zur Suchmaschinenoptimierung” (Google-Support-Seiten 2019) genannt wird, entspricht jenem, der Journalisten in den besten Ausbildungen der Welt gelehrt wird. So finden sich viele der Anweisungen zum größten Teil auch im journalistischen Standardwerk Associated Press-Handbuch “Journalistisches Schreiben” (2017) wieder.

Es zeigt sich somit auch in den Bestrebungen der Veröffentlichungen von Google, dass die Suchmaschine die Seitenbetreiber dazu anhalten möchte, qualitativ möglichst hochwertige Inhalte für die Nutzer zu schaffen. Der Hintergrund ist leicht gefunden: Je besser die Suchergebnisse von Google, desto größer die Zufriedenheit der Nutzer, desto öfter werden die Nutzer immer wieder Google benutzen. Und eine hohe Anzahl an Usern ist die Geschäftsgrundlage des Suchmaschinengiganten.

Google hat seit Bestehen nur das Gleiche herausgefunden und zu Ranking-Faktoren erklärt, was lange Zeit nur großangelegten wissenschaftlichen Studien vorenthalten blieb: Wie wir Menschen Inhalte am liebsten konsumieren. Hier gilt oftmals das Gleiche wie im Medium Zeitschrift, Radio oder TV. Nur, dass Google selbst die Daten zur Verfügung hat.

Gute Online-Marketer können heutzutage den Weg selbst gehen: Mit einem guten Splittesting-Verfahren, etwas Verständnis von Statistik (vor allem dem Unterschied zwischen Korrelation und Kausalität) und etwas technischem Know-How kann gezielt beobachtet werden, wie Dokumente im Web am liebsten von Usern konsumiert werden.

Natürlich gibt es spezifische Unterschiede zwischen den Medien, aber auch genug Ähnliches wie zum Beispiel: Auf welche Headlines reagieren wir? Auf welche Bilder reagieren wir? Auf welche Videos reagieren wir? Wie müssen Texte, Videos und Audios aufgebaut sein, damit wir weiter lesen, weiter ansehen und weiter hören möchen?

Der Unterschied zu den analogen Medienkanälen liegt banal gesagt darin, dass wir direkt mit den Inhalten interagieren können – mit einem Klick, mit einem Kommentar, einem Like, einem Kauf und vielem mehr..

Der Entwicklungsansatz von modernen Suchmaschinen

Bereits vor Google gab es Inhalte im Internet. Wie bereits in der Einführung erwähnt, verließen sich ältere Suchmaschinen wie Altavista und Co. aber auf zu leicht manipulierbare Rankingfaktoren wie Meta-Keywords. Google ging dann einen anderen Weg und erkannte Backlinks als wichtigen Rankingfaktor. Kurz gesagt: Google ging als erstes davon aus, dass wenn ein Seitenbetreiber auf die Website eines anderen Seitenbetreibers verlinkt, dann muss er das deswegen tun, weil er dessen Inhalte und Website gut findet. Nachdem aber auch dieser Rankingfaktor alleine relativ leicht zu manipulieren ist, mussten verlässliche Rankingfaktoren entwickelt werden. Und diese sollten mit großer Sicherheit über die Qualität des Dokuments für den User etwas aussagen können.

Die logische Konsequenz ist also eine Verhaltensanalyse, wie Menschen das Internet konsumieren. Und je nachdem, welches Verhalten ein Dokument auslöst, sagt das Google, ob die Inhalte gut oder schlecht sind. Daraus leitet dann Google wiederum die Anforderungen ab, die gute Websites erfüllen müssen und veröffentlicht diese auf den Google-Support-Seiten. Wenn diese wiederum eingehalten werden, schafft die Website bessere Rankings.

Die Entwicklung der Anforderungen an Websites von modernen Suchmaschinen wie Google passierte also nicht willkürlich, weil Google etwas vorgeben wollte, sondern die daraus entstandenen Anleitungen sind die Folge des Verhaltens der User.

Damit unweigerlich in Zusammenhang steht die Frage, ob Google alle Quellen wie Analytics-Accounts, Google-Ads-Accounts, GMail-Accounts etc. überwacht, um das persönliche Verhalten vieler Nutzer auszuspionieren. Fragt man Vertreter der Suchmaschine direkt, so lautete die Antwort stets “nein”. Es ist allerdings ein offenes Geheimnis, dass viele Brancheninsider Google in dieser Art und Weise nicht ganz glauben.

Laut Sistrix (Beus 2019), einem der größten SEO-Toolanbieter im deutschsprachigen Raum, ist diese Aussage zwar formal richtig, aber echte Nutzerdaten fließen in einem vorgelagerten Schritt ein. Der Toolanbieter erklärt es so:

“Google trainiert seine ML-Algorithmen (Anm.: ML = Machine Learning) (natürlich) auch mit Nutzerdaten. Als Rankingfaktor wird dann allerdings das Ergebnis aus diesem Training verwendet: der maschinenerzeugte Algorithmus und nicht mehr das Nutzerverhalten selber. Somit stimmt Googles Antwort – und doch fließt das Nutzerverhalten in das Google Ranking mit ein.”

Fazit: Usability ist langfristiger Weg zum SEO-Erfolg

“Content is King” lautet ein bekannter Online-Marketing-Leitsatz. Allerdings ist die Usability dann mindestens die Queen. Wer Usability hört, denkt meist an technische Probleme wie Funktionen, die von bestimmten Anwendungen ausgeführt werden. Die Usability beginnt aber bereits viel früher.